Sporo osób z niecierpliwością czeka na premierę iOS i iPadOS z numerem 17, oraz na zawarte w nich nowości dostępnościowe. A ponieważ nowe mobilne systemy operacyjne od Apple oficjalnie pojawią się dopiero w połowie września, to poniżej postaram się nieco ulżyć tym najbardziej niecierpliwym, opisując garść nadchodzących opcji dostępnościowych.

VoiceOver

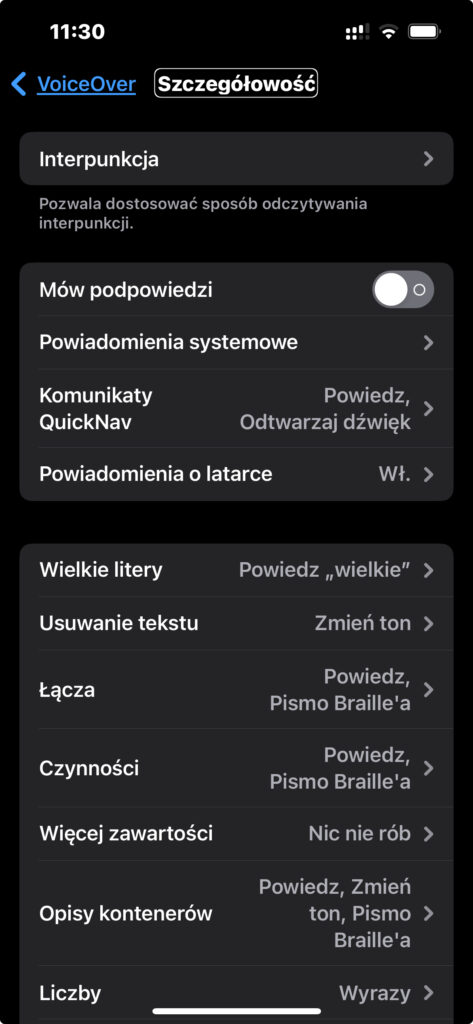

Zacznijmy od najbardziej rozbudowanej sekcji w zakładce Dostępność, czyli VoiceOver. Pierwsze nowości dostępnościowe odnajdziemy wśród opcji Szczegółowości.

Pozycja Powiadomienia Systemowe zawiera całą grupę ustawień dotyczących informowania przez VoiceOver o komunikatach systemowych wyświetlanych na zablokowanym ekranie i samych banerach powiadomień.

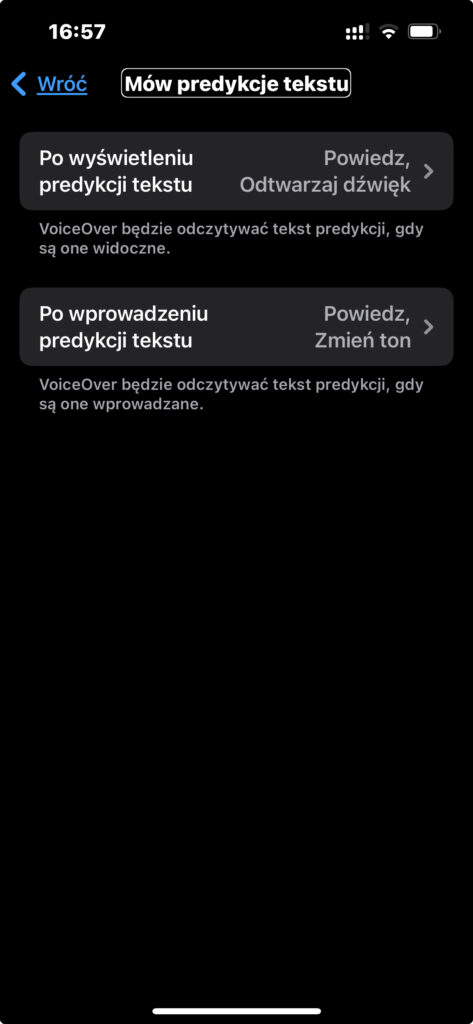

Z kolei pozycja Mów Predykcję Tekstu zawiera ustawienia VoiceOver dla nowej funkcji predykcji, jaka w iOS i iPadOS 17 pojawiła się dla języka polskiego. Dla osób niezorientowanych, chodzi tu o podpowiedzi dalszej treści, pojawiające się tuż nad klawiaturą w trakcie wprowadzania tekstu. Warto przejrzeć te ustawienia, i sprawdzić w praktyce, jak z czytnikiem ekranu najwygodniej będzie się Wam korzystało z predykcji.

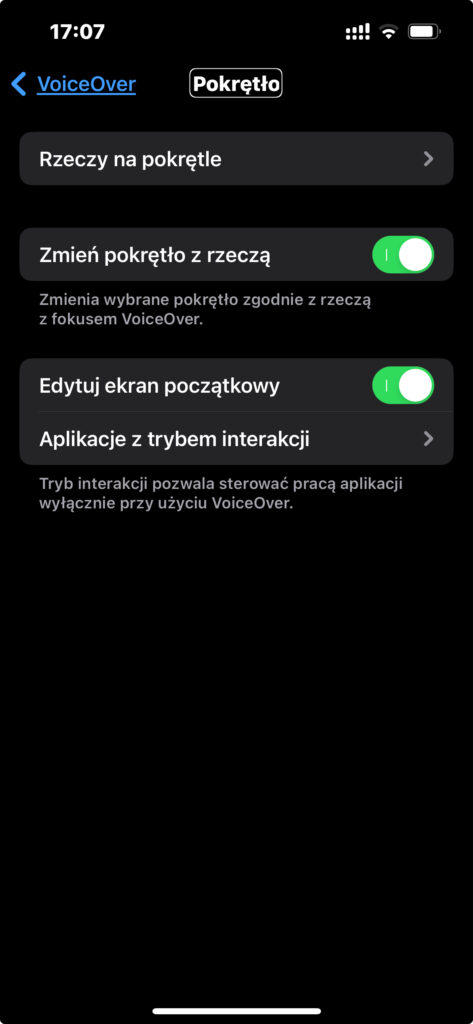

Kolejną zmianą jaką zauważymy, jest nowy układ ustawień Pokrętła.

Wcześniej mieliśmy tutaj dwie pozycje – Pokrętło oraz Czynności Na Pokrętle. W 17 wersji systemu zostały one połączone. Teraz, gdy tylko aktywujemy opcję Pokrętło, to na ekranie pojawi się kilka opcji, w tym także Rzeczy Na Pokrętle. Jest to dezorientujące dla dotychczasowych użytkowników, ponieważ pozycja Rzeczy Na Pokrętle zawiera teraz opcje dostępne wcześniej jako samo Pokrętło. Do tych opcji dodanych zostało jedynie kilka nowych pozycji związanych z brajlem.

Nowością jest pole wyboru: Zmień Pokrętło z Rzeczą. Jeśli zostanie ono zaznaczone, to Pokrętło będzie zachowywało się dokładnie tak samo, jak dotychczas. Czyli gdy fokus VoiceOver ustawicie na ikonie, to Pokrętło automatycznie przestawi się na pozycję Czynności. Jeśli fokus ustawicie na tekście, to na Pokrętle automatycznie ustawi się literowanie. A jeśli pole wyboru pozostawicie niezaznaczone, to pozycje na Pokrętle ustawiać się będą w takiej kolejności, w jakiej poukładaliście je w ustawieniach samego Pokrętła.

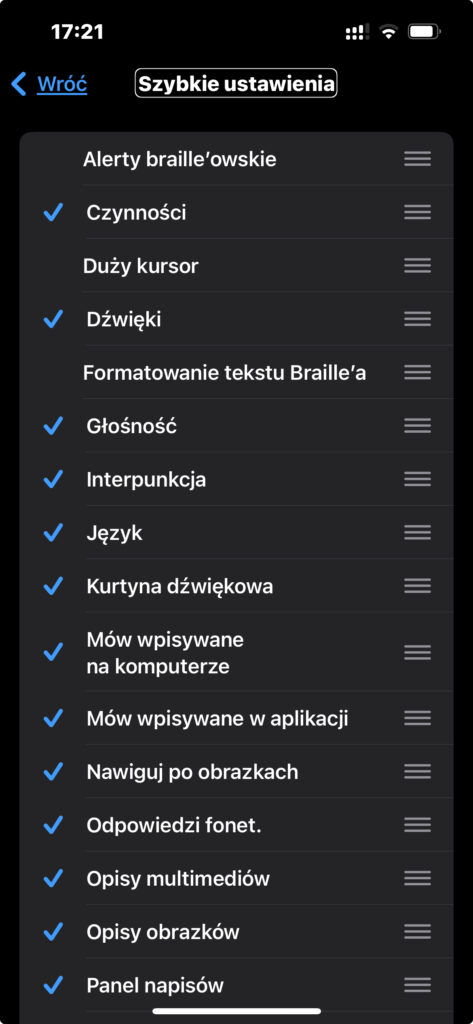

Szybkie Ustawienia to kolejny obszar, w którym znajdziemy kilka nowości. A wśród nich wymienić można następujące pozycje:

- Powiadomienia Systemowe;

- Opisuj Obrazki;

- Rozpoznawanie Ekranu;

- Kurtyna dźwiękowa;

- Formatowanie tekstu brajla.

Część opcji, które trafiły do szybkich ustawień doskonale znamy ze wcześniejszych wersji systemów iOS oraz iPadOS. Część jednak jest nowa. Wszystkie opcje możemy dodawać także w ramach gestów w ustawieniach Poleceń.

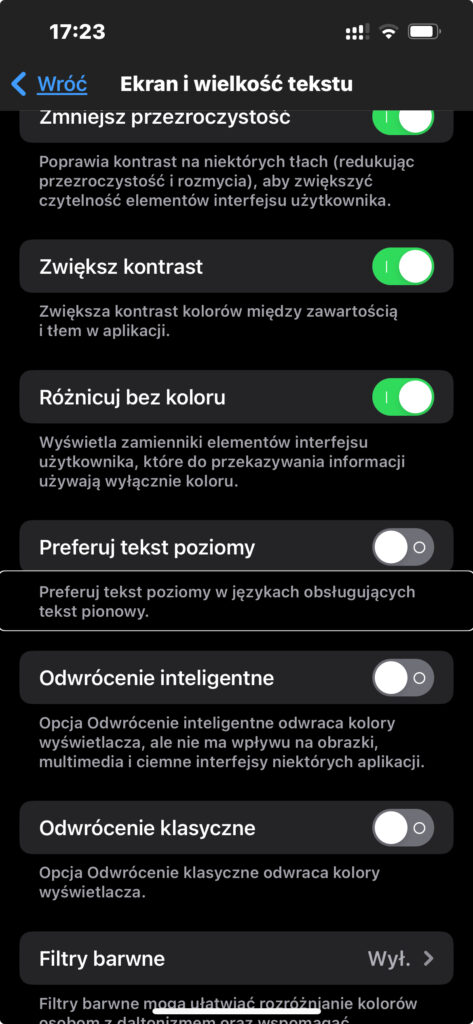

W kolejnej sekcji – Ekran i Wielkość tekstu również pojawiła się nowa funkcja o dość jednoznacznej nazwie: Preferuj Tekst Poziomy. Po jej zaznaczeniu, iPhone preferował będzie wyświetlanie tekstu poziomego w językach obsługujących tekst pionowy.

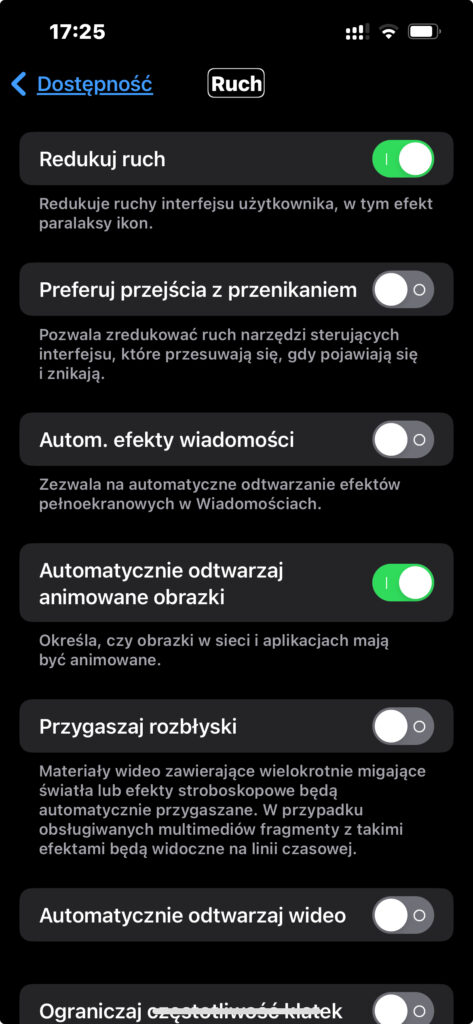

Sekcja Ruch otrzymała kilka bardzo interesujących dodatków. Ich aktywowanie będzie miało wpływ na treści przeglądane w internecie. Pierwszą jest: Automatycznie odtwarzaj animowane obrazy. Jeśli ją odznaczymy, to obrazki w sieci i aplikacjach nie będą animowane automatycznie.

Kolejna opcja to: Przygaszaj rozbłyski. Jest ona szczególnie ważna dla osób cierpiących na padaczkę fotogenną. Po jej zaznaczeniu materiały wideo zawierające wielokrotnie migające światła lub efekty stroboskopowe będą automatycznie przygaszane. W przypadku obsługiwanych multimediów fragmenty z takimi efektami będą widoczne na linii czasowej. Użytkownik będzie mógł wcześniej, świadomie zdecydować, czy chce się z nimi zapoznać, czy nie. Jest to kolejna Opcja Ułatwień Dostępu wprowadzona przez Apple, uwzględniająca wymogi międzynarodowego standardu dostępności cyfrowej WCAG.

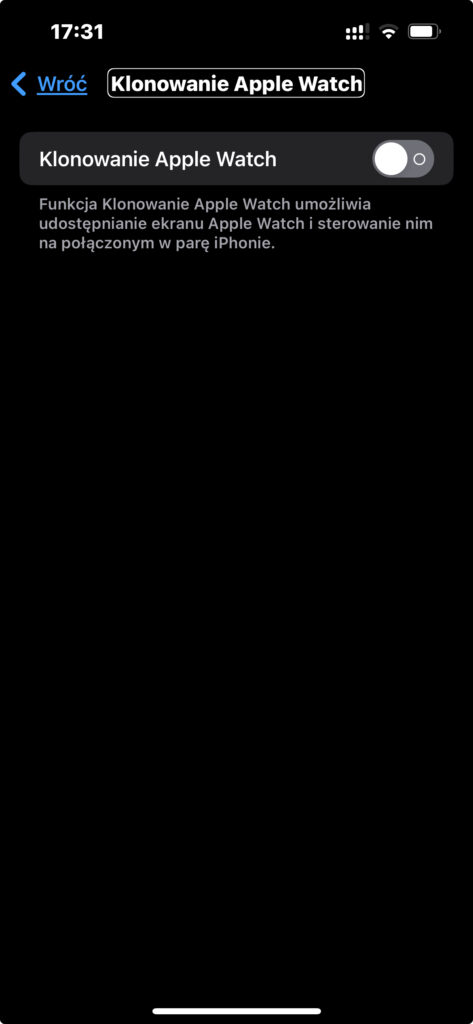

Sekcja Ruch i Motoryka również zawiera jedną nową pozycję, o wszystko mówiącej nazwie Klonuj Apple Watch. Za jej pomocą, osoby z niepełnosprawnością manualną, mogą znacznie wygodniej obsługiwać inteligentny zegarek od Apple, korzystając ze znacznie większego ekranu iPhone. Co istotne, ta opcja jest w pełni dostępna dla użytkowników czytnika ekranu VoiceOver.

W sekcji Słuch, a dokładnie opcji Rozpoznawanie Dźwięku, pojawiło się kilka nowych odgłosów, które mogą być automatycznie wykrywane przez nasze iUrządzenie. Wśród nich znajdziemy m.in. miałczenie kota, pokasływanie, czy odgłos płonącego ognia. Działanie samej funkcji demonstrowałem w nagraniu opublikowanym we wpisie Nowości w iOS14 – Rozpoznawanie dźwięku.

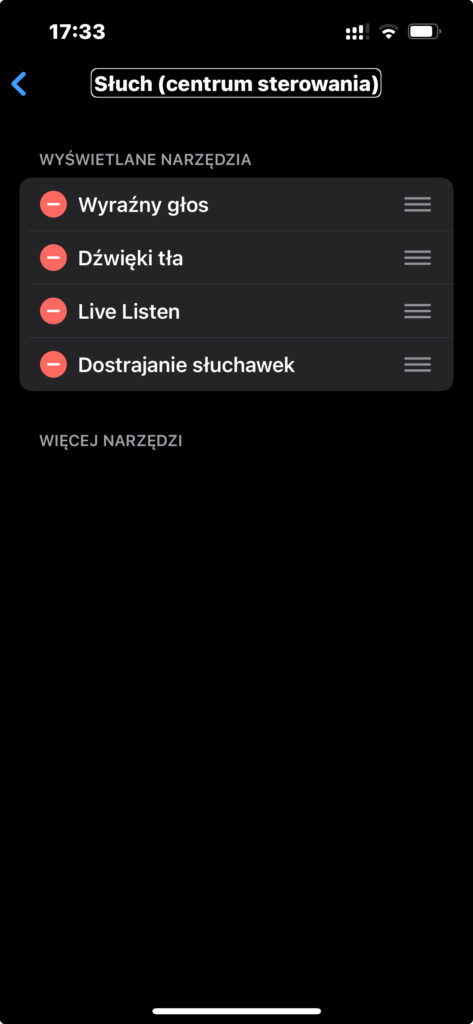

W tej sekcji znajdziemy również całkowicie nową pozycję, tj. Słuch – Centrum Sterowania. Możemy w niej włączyć wyświetlanie w Centrum Sterowania m.in. następujących opcji:

- Dostrajanie słuchawek;

- Dźwięki tła;

- Live Listen;

- Wyraźny głos.

Aby móc korzystać z ww. opcji, musimy najpierw w Ustawieniach Centrum Sterowania na liście dostępnych pozycji zaznaczyć Słuch. Wtedy w Centrum Sterowania pojawi się nowy element anonsowany przez VoiceOver jako Aparaty Słuchowe. Gdy go aktywujemy, na ekranie wyświetlone zostaną wybrane wcześniej opcje. Pamiętajcie też, że część z wymienionych funkcji będzie aktywna dopiero wtedy, gdy do iPhone podłączycie słuchawki.

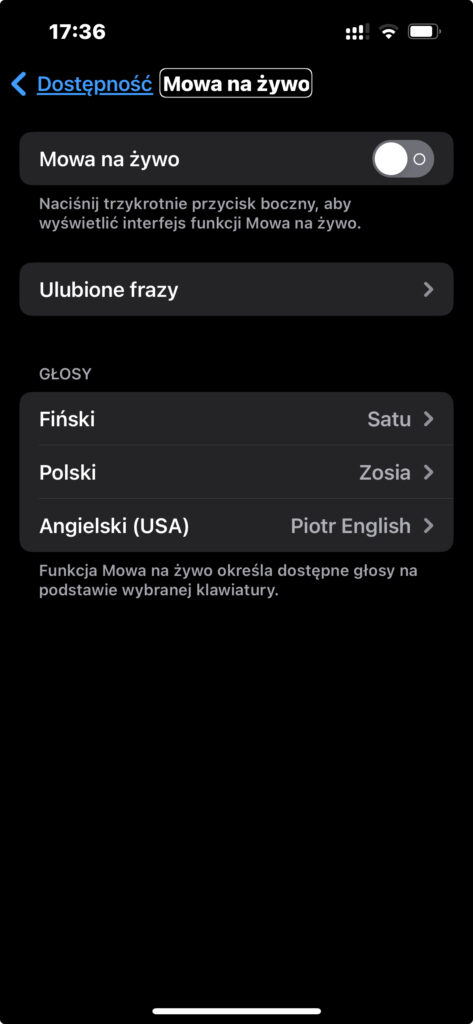

W ustawieniach Dostępności pojawiła się zupełnie nowa sekcja o nazwie Mowa. Znajdują się w niej dwie pozycje: Mowa na żywo, oraz Głos indywidualny. Pierwsza umożliwi osobom Głuchym lub z innych względów niemogącym mówić, przekazywanie w trakcie rozmowy audio komunikatów głosowych za pomocą wbudowanych syntezatorów mowy. Czyli jest to funkcja Tekst Na Mowę, a nie jak podają wszystkie agencje prasowe – Mowa Na Tekst. Co ciekawe, syntezator mowy jest automatycznie dobierany pod kątem języka klawiatury z jakiej korzysta osoba mająca problemy z mówieniem. W ten sposób użytkownik iPhone niemogący mówić, nareszcie będzie miał możliwość zadzwonienia na jeden ze zwykłych numerów alarmowych i przekazania prośby o pomoc, skorzystania z automatycznej infolinii obsługiwanej przez sztuczną inteligencję, czy zwykłego powiedzenia telemarketerowi, co sądzi o nękających go połączeniach. 😉

Druga opcja umożliwia stworzenie tzw. Indywidualnego Głosu, czyli syntezatora mowy, który w systemie wykorzystywał będzie nasz własny głos. Procedura jest dość prosta. Wystarczy wyraźnie przeczytać 150 krótkich fraz. Czytać możemy ciągle, albo zdanie po zdaniu. Niestety, przynajmniej narazie funkcja obsługuje jedynie język angielski. Dla użytkowników VoiceOver istotna jest jeszcze informacja, że w trakcie procesu nagrywania synteza mowy czytnika jest ściszana. Dlatego przy tworzeniu własnego głosu sugeruję skorzystać ze słuchawek. A ponieważ tworząc własny syntezator mowy archiwizujemy wrażliwe dane, jakimi są próbki naszego głosu, z tej opcji skorzystać będziemy mogli dopiero wtedy, gdy urządzenie autoryzuje nasze Face/Touch ID, lub gdy podamy prawidłowy kod zabezpieczający naszego iUrządzenia.

Więcej na temat obu funkcji opowiadam w nagraniu opublikowanym we wpisie Mowa Na Żywo oraz Głos Indywidualny, czyli dwie nowości dostępnościowe w iOS17.

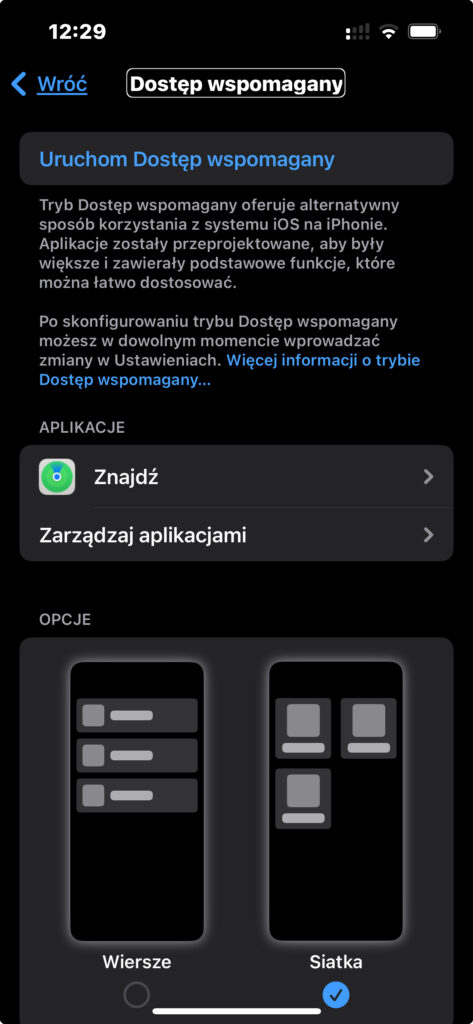

Również w sekcji Ogólne pojawiła się całkowicie nowa pozycja o nazwie Dostęp Wspomagany, dedykowana użytkownikom o ograniczonych zdolnościach kognitywnych. Po jej włączeniu i skonfigurowaniu będziemy mogli korzystać z przeprojektowanych aplikacji. Są one bardziej przejrzyste i zawierają tylko podstawowe funkcje, z których można łatwo, szybko i wygodnie korzystać. Po skonfigurowaniu Dostępu Wspomaganego, w dowolnym momencie można później wprowadzać zmiany w jego Ustawieniach. Przykładowo jeśli osoba korzystająca z iUrządzenia preferuje tylko komunikację wizualną, to na przykład aplikację Wiadomości możemy skonfigurować jej w taki sposób, aby zamiast klawiatury wyświetlały się jedynie ikony emoji i opcja kamery video.

Gdy aktywujemy opcję Skonfiguruj Dostęp Wspomagany, uruchomiony zostanie kreator prowadzący nas krok po kroku. Na początku wskazujemy osobę, która korzystać będzie z tego trybu, i której Apple ID zostanie powiązane z nową funkcją. Zaraz potem możemy wybrać sposób wyświetlania ikon oraz tekstu w trybie Dostępu Wspomaganego. Zobaczyć, które z systemowych aplikacji już posiadają ustawienia dla tego trybu, a które jeszcze możemy dodać, aby móc je odpowiednio skonfigurować. Dowiemy się także o kilku różnicach w działaniu samego trybu, i będziemy mogli ustawić kod numeryczny, dzięki któremu możliwe będzie opuszczenie Dostępu Wspomaganego. A to akurat warto wiedzieć, że aby opuścić wspomniany tryb należy albo znaleźć odpowiedni przycisk w Centrum Sterowania, albo trzykrotnie nacisnąć boczny przycisk, a następnie wprowadzić ustawiony wcześniej kod. Użytkowników VoiceOver od razu przestrzegam przed zabawą z wykorzystaniem tego trybu. Przynajmniej na razie, po jego włączeniu czytnik ekranu działa bardzo niestabilnie. Może jest to kwestia związana z wersją testową systemu, ale ostatecznie nie ma to żadnego znaczenia. Wspominam o tym, żebyście później nie pisali w komentarzach, że nie ostrzegałem. 😉

Nowe opcje dostępne w modelach Pro

Ponieważ wersję testową zainstalowaną mam tylko na iPhone Pro, nie mam jak sprawdzić, czy opisywane poniżej nowości pojawią się również na zwykłych modelach. Dotychczas Tryb Wykrywania obecny był jedynie na iUrządzeniach wyposażonych w Lidar.

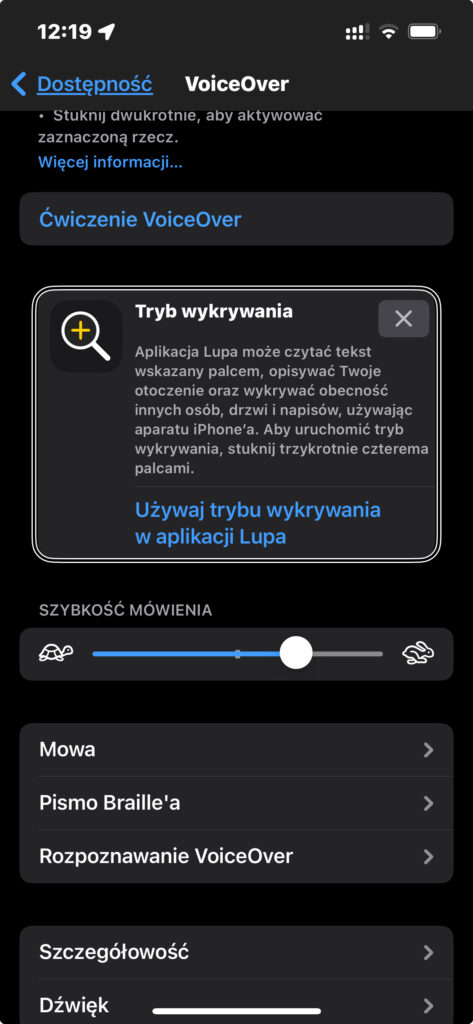

Na pierwszy sygnał, że pojawiła się jakaś nowość, natrafimy zaraz po wejściu w ustawienia VoiceOver. Znajduje się tam następująca podpowiedź:

Porada Tryb wykrywania , Aplikacja Lupa może czytać tekst wskazany palcem, opisywać Twoje otoczenie oraz wykrywać obecność innych osób, drzwi i napisów, używając aparatu iPhone’a. Aby uruchomić tryb wykrywania, stuknij trzykrotnie czterema palcami.

I oczywiście okazało się wtedy, że wcześniej zdążyłem już zagospodarować ten gest na zrobienie zrzutu ekranu. Więc w ustawieniach VoiceOver, w sekcji Polecenia, pod pozycją Gesty i Dotyk musiałem dokonać kilku zmian. Zrzut Ekranu przeniosłem na inny gest, a do trzykrotnego stuknięcia czterema palcami podpiąłem domyślną opcję, czyli Tryb Wykrywania. Wspominam o tym, gdybyście byli w podobnej sytuacji. Oczywiście tę opcję możemy podłączyć pod każdy inny z dostępnych gestów.

Dotychczas do Trybu Wykrywania można było dotrzeć tylko za pośrednictwem systemowej Lupy, o czym mówiłem m.in. w nagraniu o iOS16 i Trybie Wykrywania drzwi, oraz ich numerów i różnych symboli. Teraz oprócz bardzo okrężnej drogi, do dyspozycji mamy wygodny gest, błyskawicznie uruchamiający mocno rozbudowaną funkcję.

Wcześniej Tryb Wykrywania umożliwiał nam jedynie wykrywanie osób oraz drzwi. W iOS17 otrzymaliśmy dwa kolejne, czyli Wykrywanie Tekstu, oraz Tryb Wskaż i Mów.

Pierwsza z nowości powinna działać mniej więcej tak jak rozpoznawanie krótkiego tekstu w aplikacjach Seeing AI czy Seeing Assistant Home. Piszę mniej więcej, ponieważ wersja systemowa dodatkowo automatycznie wykrywa język tekstu i pod tym kątem dobiera odpowiedni syntezator mowy. Jest to super rozwiązanie, pod warunkiem, że próbujemy zapoznać się z treścią przygotowaną w jednym z języków obsługiwanych przez Siri. Jeśli jednak próbujemy rozpoznać tekst napisany po polsku, to system głupieje i co chwilę zmienia syntezę, próbując dopasować ją do nieznanego języka. Oczywiście w ustawieniach funkcji można wyłączyć automatyczną syntezę i odczytywać rozpoznaną treść na ekranie iPhone za pomocą VoiceOver, ale do jej rozpoznawania wykorzystywane są algorytmy stworzone dla innych języków, więc na ekranie również pojawiają się same głupoty. Ergo, przynajmniej w tym momencie funkcja Wykrywanie Tekstu nie obsługuje języka polskiego.

Tryb Wskaż i Mów to funkcja, na którą czekało wiele osób. Polega ona na tym, że wystarczy palcem wskazać co dokładnie nas interesuje, kamerę iPhone skierować na nasz palec, a system syntezatorem mowy poinformuje nas co wskazujemy. Odczytywane mają być teksty i interpretowane piktogramy. W ustawieniach wybieramy, czy system anonsować ma to co znajduje się nad czy pod naszym palcem. I choć opis brzmi świetnie, to samo działanie funkcji pozostawia wiele do życzenia. Ewidentnie musimy jej stworzyć dobre warunki oświetleniowe, i najlepiej wskazywać teksty napisane w jednym z języków Siri.

Dodatkowe Udogodnienia

Wśród dodatkowych funkcji powiązanych z technologiami asystującymi i Opcjami Ułatwień Dostępu, które zostały rozbudowane w iOS/iPadOS 17 w tym momencie mogę jeszcze wymienić:

- Sterowania Głosowe – Otrzymało możliwość tworzenia słownika z nowymi wyrazami oraz kontekstową interpretację podobnie brzmiących poleceń;

- Sterowanie Przełącznikami – Pozwala zamienić dowolny przełącznik w kontroler do gier;

Siri – Przy korzystaniu z VoiceOver, głos asystentki brzmi naturalnie nawet przy dużej prędkości wypowiedzi. Co istotne, można teraz przyśpieszyć Siri nawet do 200% jej dotychczasowego maksymalnego tempa.

Oczywiście, tradycyjnie, o wielu nowościach dostępnościowych Apple w ogóle nas nie powiadamia. Są to na przykład takie drobiazgi, jak anonsowanie przez VoiceOver informacji, na jaki nr otrzymaliśmy wiadomość w sytuacji, gdy w iPhone posiadamy więcej niż jedną kartę SIM. Albo anonsowanie w Kalendarzu, że dany wpis jest nowy. Co ogromnie się przydaje, gdy mamy podpiętych kalendarze kilku członków zespołu. Myślę, że takich drobnych zmian jest dość sporo i z czasem będziemy je odkrywać. A jeśli sami zauważyliście już jakieś, napiszcie proszę o nich w komentarzu, to uzupełnię powyższe zestawienie.

Oprócz takich sensu stricto dostępnościowych nowości, iOS i iPadOS zawierają także kilka udogodnień ułatwiających życie użytkownikom. Wśród nich na pewno wymienić można regulację natężenia światła Latarki, czy możliwość pingowania Apple Watch. Jest ich oczywiście znacznie więcej, ale każdy z nas zwykle zwraca uwagę tylko na te kwestie, które dotyczą nas bezpośrednio. Dlatego sam jestem ciekaw na jakie zmiany Wy zwrócicie uwagę. Premiera nowych systemów mobilnych od Apple odbędzie się za nieco ponad dwa tygodnie, więc dość szybko będziecie mieli sposobność przekonać się, czy opisywane powyżej nowości przypadną Wam do gustu.

Dla mnie chyba najfajniejszy jest „tryb wykrywania”. Działa na prawdę super i szkoda, że jest dostępny tylko w modelach Pro.

Jak na razie funkcja „Powiadomienia” zachowuje się lekko dziwnie, pisałem gdzieś o tym wcześniej ale jeżeli mamy zaznaczoną pozycję „Pismo brajla” to wówczas VO będzie zachowywało się tak jakbyśmy mieli zaznaczoną opcję „mowa”. Teraz beta ma już literkę A, więc jedyne kiedy mogą to poprawić to w wersji RC, a raczej tego nie zrobią.

U mnie niestety nie działa w ogóle. 🙁 Zrobiłem o tym nagranie, które puszczę w przyszłym tygodniu.

Pytanie laika, co to jest Automatycznie odtwarzaj animowane obrazy. Czy mógłby ktoś dać jakiś przykład

To najczęściej są proste grafiki, które wykonują proste ruchy. Na przykład tekst, który się powiększa i pomniejsza itp.

Dzięki Piotr. Nawet nie wiedziałem, że coś takiego istnieje

Ciekawe Piotrze. No poczekam na Twoje nagranie, może będę w stanie coś podpowiedzieć.